Table des matières

Electifs

Quatre jeux d’électifs sont proposés. Aucun électif n’a de prérequis autre que l’envie de le suivre, c’est donc un bon moment pour se spécialiser ou se diversifier selon ses inclinaisons ou son projet professionnel. Les options sont divisées en trois grandes thématiques : la data science, les systèmes d’information, les approfondissement thématiques.

Data Science

Deux électifs pouvant être pris indépendamment :

- Data Science (DS1)

- Deep Learning (DS2)

Le terme data science semble avoir été inventé par William Cleveland dans un article programmatique paru en 2001 intitulé « Data Science: An Action Plan for Expanding the Technical Areas of the Field of Statistics ». La discipline est particulièrement jeune et actuelle, avec un développement extrêmement fort de sociétés et de services innovants (voir le salon datajob), donc d’emplois, et depuis quelques années de formations académiques dans le domaine. Elle est liée, mais pas uniquement, au phénomène big data et à la numérisation systématique des données de quelque nature que ce soit (traces de cartes bleues, de péages, de gps, sites visités sur internet, achats réalisés en ligne, amis déclarés sur les réseaux sociaux, etc), ce que l’on nomme datafication. Le marché économique concerné par la data science est d’ores et déjà gigantesque, et ne cesse de croître (il n’y a qu’à regarder le poids des acteurs économiques majeurs les plus utilisateurs de ces technologies: Google, Microsoft, Amazon, Facebook ou encore Lnkedin).

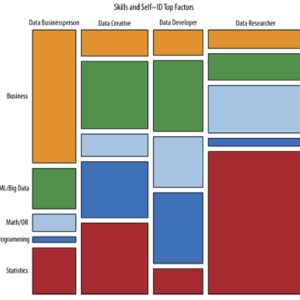

Le domaine de la data science s’est largement construit sur l’essor et la maturité de techniques d'apprentissage automatique (machine learning) et plus généralement d'intelligence artificielle. La data science est une science jeune à la croisée de mathématiques et informatique. Le data scientist possède de fortes compétences en informatique, programmation et algorithmique, gestion et manipulation de données, ingénierie des données, et en mathématiques avec notamment des compétences en probabilités et statistiques mais aussi en optimisation numérique. Enfin, le data scientist doit posséder une certaine expertise métier sur les données qu’il est amené à manipuler et les tâches qu’il doit réaliser.

Profils

La data science correspond ainsi un spectre très large de compétences qu’une personne peut difficilement maitriser seule. Il n’y a donc pas un mais plusieurs profils de data scientists, le parcours OMIS en formant trois :

- certains plus mathématiques (adossé au parcours M),

- d’autres plus informatiques (adossé au parcours I),

- et enfin des profils plus axés sur les usages, la visualisation et les problèmes métiers (adossé au parcours O).

Deux électifs

Electif DS1 : Data Science

Le cours de Data Science introduit la science des données à travers un panorama de l’apprentissage automatique et de l’apprentissage statistique : paradigmes d’apprentissage supervisé et non supervisé, méthodes de référence en discrimination linéaire et non linéaire (plus proche voisin, méthodes neuronales, méthodes à noyaux), théorie de l’apprentissage statistique, dimension de Vapnik, notions de surapprentissage et généralisation, stratégies de régularisation, stratégies d’optimisation (descente de gradient notamment), etc.

Le cours est partagé en séances de cours pour introduire les aspects fondamentaux et en des travaux sur machine avec le langage python. Les exemples utilisés en TP sont issus de cas réels et concerneront notamment des tâches de recommandation de produits (films, videos, livres etc), de filtrage automatique d’emails, de détection de fraudes (par ex. cartes bancaires), d’inférence d’information dans des réseaux sociaux (prédiction de lien), etc.

Pour en savoir plus:

- Doing Data Science, Straight Talk from the Frontline, By Cathy O'Neil, Rachel Schutt, Publisher: O'Reilly Media, October 2013

- Learning scikit-learn: Machine Learning in Python , Raúl Garreta, Guillermo Moncecchi, Publisher: O'Reilly Media, 2013

- Chris Bishop: Pattern Recognition and Machine Learning, On-line edition

Electif DS2 : Deep Learning

Élu par le MIT comme l’une des 10 plus grandes avancées technologiques en 2013, le deep learning réunit des algorithmes du domaine de l’apprentissage automatique ou “machine learning” pour simuler le fonctionnement de l’activité neuronale d’un cerveau humain. Pour Y. LeCun, directeur du centre de recherche en Intelligence Artificielle de Facebook : Le cerveau des humains et des animaux est « profond », en ce sens que chaque action est le résultat d’une longue chaîne de communications synaptiques qui représentent plusieurs couches de traitement. L’apprentissage profond tente de faire quelque chose de similaire dans les machines. Nous créons des réseaux de neurones computationnels, à plusieurs couches de profondeur, qui peuvent apprendre à représenter des caractéristiques du monde, qu’il s’agisse de mots, d’images ou autres.

L’apprentissage profond est un paradigme d’apprentissage automatique très récent qui a remis au gout du jour les réseaux de neurones artificiels qui ont été mis au point dans les années 1980 et qui avaient rencontré certaines limitations. Les travaux en deep learning ont permis des avancées majeures sur plusieurs problèmes réputés difficiles, notamment des tâches de perception (vision, audition) et plus généralement pour des tâches d’inférence d’une information linguistique (compréhension du langage, détection d’opinion). Aujourd’hui ces systèmes envahissent tous les champs applicatifs de l’apprentissage automatique et sont intégrés dans des systèmes industriels chez de multiples acteurs y compris les plus grands (Google, Microsoft, Amazon, Facebook, etc).

Le cours fera une part importante au développement logiciel en python de modèles neuronaux profonds, en mettant l’accent sur la qualité des représentations intermédiaires des données et sur les moyens pour les obtenir, et sur des tests grandeur nature à l’aide de calcul GPU sur des problèmes complexes de reconnaissance d’objets dans les images et plus généralement sur des tâches de computer vision, et enfin sur l’annotation automatique d’images par mots-clés.

Pour en savoir plus :

- Y. LeCun, New York university (NYU): Regarder les slides et la video de Week 1

- Yoshua Bengio, Learning Deep Architectures for Artificial Intelligence

Systèmes d'information

Deux électifs pouvant être pris indépendamment :

- Systèmes d'Information (SI1)

- Management par les Systèmes d'Information (SI2)

Les systèmes d’information sont devenus une composante essentielle du fonctionnement et de la performance des organisations. Ils ont des impacts sur les performances des entreprises en contribuant à l’optimisation opérationnelle (ERP), à la création de nouvelles opportunités commerciales (CRM…), en facilitant le reporting et la prise de décision (business intelligence). Ils sont aussi au cœur de l’organisation du travail et des modalités de coopération entre les acteurs de l’entreprise.

Pour que le système d’information constitue un atout pour les organisations, sa robustesse et sa fiabilité sont indispensables : ces qualités s’apprécient sous l’angle technique (architecture logicielle, caractéristiques des données), juridique (droit des données), mais aussi en fonction de l’aptitude du SI à répondre pleinement aux besoins spécifiques qui lui sont adressés (analyse de la demande et des processus métiers).

Ce sont ces thématiques qui sont déclinées dans deux électifs qui se veulent complémentaires mais peuvent aussi être suivis indépendamment l’un de l’autre selon la coloration que chaque élève souhaite donner à son parcours. L’électif SI1 est centré sur le développement des systèmes d’information, depuis l’analyse des besoins jusqu’à la modélisation du système, tandis que l’électif SI2 cible davantage les problématiques de management par les systèmes d’information.

Profils

Les compétences développées par ces électifs peuvent satisfaire les trois profils disciplinaires de l’option OMIS

- Pour les M. : l’architecture des systèmes d’information et leur paramétrage conditionnent les possibilités d’extraction et de représentation des tendances, par exemple pour le reporting et la prise de décision. En ce sens, les S.I. constituent un domaine applicatif des méthodes statistiques.

- Pour les I : l’infrastructure technologique du SI fait appel à des compétences en matière de génie logiciel, de plateformes matérielles, de systèmes d’exploitation, d’équipements de réseaux, de services web.

- Pour les O : en tant que support intégré des processus, des métiers et de la prise de décision, les systèmes d’information sont une composante essentielle de l’organisation des entreprises aujourd’hui. Les problématiques organisationnelles jalonnent toutes les étapes de la conception à la mise en place du S.I. et jusqu’à l’analyse des impacts sur les relations humaines et managériales.

Approfondissements thématiques

- Développement java/C#

- Programmation VBA et excel

- Recherche d’information

- Administration Réseau

- Gestion des risques

- Calcul scientifique

- Partenariat avec l’institut Galilée

- Ergonomie et lean service

SAS et données

Cette UE pratique permet aux étudiants de connaitre les bases du logiciel SAS très utilisé en banques et assurances. On y verra également des petites routines en python permettant de gérer ses données (fichiers excel, pdf, etc).

Programmation VBA et excel

Ce cours permet de mettre en œuvre et de synthétiser un ensemble de connaissances diverses (informatique, mathématique, physique) dans le cadre d’un nouveau langage (VBA) tout en restant dans un environnement connu (MS Excel). Les nouvelles compétences acquises sont transversales et permettent à l’ingénieur Centralien de disposer d’outils polyvalents en matière de gestion des moyens techniques, financiers et humains.

Cette UE a pour objectifs :

- de maîtriser l’utilisation de MS Excel en utilisation “tableur”, avec les fonctions disponibles, la gestion et la représentation des données, les graphiques.

- de maîtriser les outils scientifiques spécifiques de MS Excel (Outil Valeur Cible, fonctions de tableaux, Solveur)

- de découvrir et de pratiquer l’environnement de programmation VBA.

- de pouvoir réaliser une application scientifique avec un contenu de calcul et une interface utilisateur de type MS.

Recherche d’information

Avec la mise en réseau et l'augmentation des capacités de stockage et des vitesses de traitement, les quantités de données recueillies et stockées on considérablement augmenté ces dernières années. Ce changement d'échelle pose de nouveaux défis pour les technologies d'archivage et de recherche d'information. Leur mise en oeuvre fait appel à des techniques algorithmiques novatrice et en constant développement. Nous verrons dans ce cours un panorama de ces méthodes et techniques, d'un point de vue théorique et pratique.

Nous verrons en particulier :

- Comment évaluer les performances d’un programme de recherche d’information?

- Les méthodes d'indexation de documents

- Classification de documents

- Recherche web

- Systèmes de recommandation

Administration Réseau

Les réseaux IP sont aujourd’hui au cœur de quasiment toutes les activités économiques : ils impactent les organisations (messagerie, téléphonie, architectures Orientées Services, nomadisme, mobilité), les bureaux d’études (partage de ressources, travail collaboratif), les ressources humaines (télétravail, intranet, réseaux privés virtuels), les implantations industrielles (réseaux de capteurs, télésurveillance, intégration voix, données, images), les échanges commerciaux (B2B, B2C)…

Cette UE permet de donner de solides compétences opérationnelles en réseaux, parfaitement structurées, de façon à ce qu’ils puissent tirer le meilleur profit des évolutions technologiques qu’ils ne manqueront pas de voir apparaître tout au long de leur carrière

Seront abordés :

- Bases réseau IP

- Protocoles et couches réseaux

- Administration d’un réseau local

Gestion des risques

L'objectif de ce cours est de présenter les problématiques en gestion du risque industriel et plus particulièrement dans le domaine du nucléaire. On abordera à partir d’exemples les méthodes statistiques d'analyse et de gestion du risque. Des travaux pratiques sur machine seront proposés.

Description du programme :

- Introduction à l’analyse de risque

- Modélisation et propagation probabiliste de l’information incertaine

- Modélisation de données par méthodes de régression

- Méthodes de la géostatistique : cas de la géostatistique stationnaire et cas de la géostatistique non stationnaire

- Mini projet sur la cartographie pour la télésurveillance de l’environnement à l’aide des techniques géostatistiques

- Plan d’expérience, analyse de sensibilité

- Modélisation de l’information dans le cadre des théories de l’incertain

- Propagation et fusion d’information dans le cadre des théories de l’incertain

Calcul scientifique

En deux partie. Tous les schémas abordées seront mise en oeuvre sous Scilab.

La première partie est consacrée aux équations linéaire. Elle permettra d'aborder :

- Equations scalaires : propriétés mathématiques, méthode des caractéristiques.

- Système d’équations : propriétés, plan de phase.

- Résolution de problèmes de Riemann, exemple de l’acoustique.

- Schémas numériques : problème de consistance et stabilité ; étude des schémas Volumes finis ; upwind Lax-Wendroff ; problème de diffusion et de dispersion numérique. Schéma limiteur de flux.

La seconde partie traitera des équations non-linéaires. On y verra :

- Equations scalaires : méthode des caractéristiques, solutions discontinues, relations de Rankine Hugoniot, entropie.

- Systèmes : plan de phase, courbes d’Hugoniot, ondes de choc et de raréfaction.

- Schémas volumes finis : Roe, Lax-Friedrich, schémas d’ordre élevé.

Partenariat avec l’institut Galilée

Une semaine de cours en partenariat avec l'institut Galilée. Le programme change chaque année.

Ergonomie et lean service

Electif en deux parties permettant de mieux appréhender le facteur humain, cruxial dans les services.

La première partie consacrée à l'ergonomie montre la place cruciale de l’homme au sein de tout service, qu’il soit organisationnel ou informatique. On recentrera ainsi tout processus autour de celui qui les utilisera. On étudiera différents modèles et leurs conséquences quant au design du projet à réaliser.

La seconde partie, en partenariat avec DynEo, est un atelier montrant par l'exemple la gestion d'un projet en utilisant la méthode Lean Service.